Anthropicは、最新のAI言語モデルであるClaude 3.5 Sonnetのリリースを発表しました。これは、リリース済みのClaude 3をベースに構築された新しい「3.5」モデルシリーズの最初のものです。Claude 3.5は、テキストの作成、データの分析、コードの記述が可能です。 200,000 トークンのコンテキスト ウィンドウがあり、Claude の Web サイトおよび API 経由で現在利用可能です。 Anthropic は、関連する作業文書を専用ウィンドウに表示する Claude インターフェースの新機能である Artifacts も導入しました。

私たちオンクラウドAIこの記事を通じて、クロード 3.5 ソネットを詳しく調べてください。

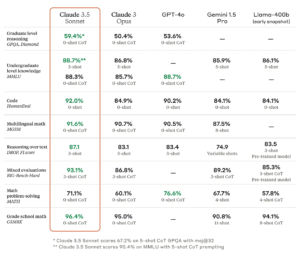

大規模言語モデル (LLM) のベンチマークは、慎重に選択される可能性があり、想像できるほぼすべてのトピックについて、機械生成出力の感覚やニュアンスを捉えられないことが多いため、問題があります。しかし、Anthropic によれば、Claude 3.5 Sonnet は、MMLU (学部レベルの知識)、GSM8K (小学校の数学)、HumanEval (コーディング) などの特定のベンチマークでは、GPT-4o や Gemini 1.5 Pro などの競合モデルと同等かそれ以上の性能を発揮します。

Claude 3.5 Sonnet は、「推論」、数学スキル、一般知識、コーディング能力を測定するベンチマークでも、Anthropic のこれまでの最高モデル (Claude 3 Opus) を上回りました。たとえば、モデルは内部コーディング評価で良好なパフォーマンスを発揮し、問題の 64% を解きましたが、Claude 3 Opus の問題では 38% を解きました。

Claude 3.5 Sonnet は、「推論」、数学スキル、一般知識、コーディング能力を測定するベンチマークでも、Anthropic のこれまでの最高モデル (Claude 3 Opus) を上回りました。たとえば、モデルは内部コーディング評価で良好なパフォーマンスを発揮し、問題の 64% を解きましたが、Claude 3 Opus の問題では 38% を解きました。

Claude 3.5 Sonnet も、画像形式での視覚入力を受け入れることができるマルチモーダル AI モデルであり、この新しいモデルは一連の視覚理解テストで優れたパフォーマンスを発揮したと報告されています。

大まかに言えば、ビジョンベンチマークでは、3.5 Sonnet は画像から情報を抽出する能力が以前のモデルよりも優れていることが示されています。たとえば、フットボールのヘルメットをかぶったウサギの写真を見せると、モデルはそれがフットボールのヘルメットをかぶったウサギであることを認識し、それについて話すことができます。これは技術デモンストレーションには楽しいものですが、信頼性が重要となる技術アプリケーションにはこの技術はまだ十分正確ではありません。

「アーティファクト」の紹介

一般ユーザーにとってさらに注目すべきは、「アーティファクト」と呼ばれる新しいインターフェース機能です。これにより、会話中に専用ウィンドウで Claude が生成したコンテンツ (コード、テキスト、Web デザインなど) を操作できるようになります。

Anthropic はこれを、Claude.ai (Web インターフェース) をチームのための共同作業スペースへと進化させるための一歩と見ていますが、長い会話のバックログに埋もれることなく人々が作業を進めるのにも役立ちます。

Anthropic によれば、Claude 3.5 Sonnet は Claude 3 Opus の 2 倍の速度で動作します。また、パフォーマンスはほぼ同等で、より安価です。新しい 3.5 モデルでは、API の入力トークン 100 万個あたり 3 ドル、出力トークン 100 万個あたり 15 ドルです。比較すると、Opus のコストは入力トークン 100 万個あたり 15 ドル、出力トークン 100 万個あたり 75 ドルです。

Claude 3.5 Sonnet には、Web サイトと API に加えて、有料ユーザーにはより高い使用制限がある Claude iOS アプリからもアクセスできます。このモデルは、Amazon の Bedrock および Google Cloud の Vertex AI プラットフォームでも利用できます。